17 décembre 2024

Le compelling event : la clé pour booster vos ventes

Pourquoi vos prévisions de ventes ne se réalisent-elles pas ? Vous êtes responsable d’une équipe commerciale et en début de…

4 octobre 2017

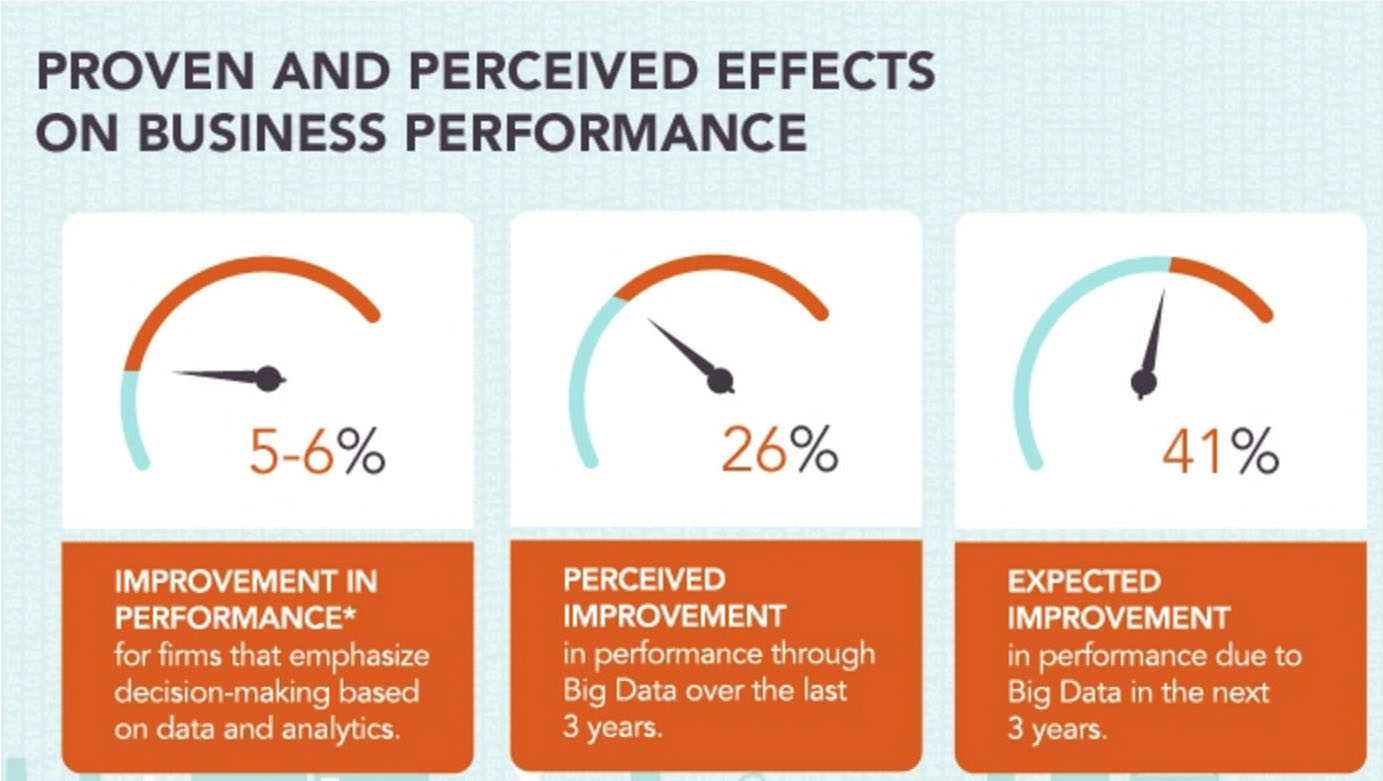

Une étude réalisée par The Economist pour le compte de Capgemini en 2011, intitulée « le facteur décisionnel : les Big Data et la prise de décision », est arrivée à la conclusion que les données jouaient un rôle de plus en plus prégnant dans la prise de décision, mais que les paroles devançaient les actes. L’étude, qui portait sur 600 décideurs dans le monde, et de tous les secteurs, visait la mesure de l’usage des Big Data dans le circuit de décision de leurs entreprises.

Ce rapport démontrait aussi que ceux qui jouaient le jeu et qui joignaient l’acte au discours s’en tiraient mieux que les autres. Toutefois, 42% avouaient éprouver des difficultés dans l’interprétation des données non structurées, et 85% montraient du doigt non pas le volume, mais la capacité à analyser et agir sur la donnée.

Cette étude avait pour mérite de mettre l’accent sur un phénomène que beaucoup décrivent intuitivement, sans pouvoir toujours le justifier par des chiffres : la technologie permet la rupture et apporte un plus indéniable ; mais celle-ci n’est rien sans la maîtrise humaine, sans l’analyse, l’interprétation et la nécessaire intelligence émotive, souvent à la source des bonnes décisions.

5 ans plus tard, où en sommes-nous, avons-nous fait des progrès, et quels sont les points de vigilance quant à la prise de décisions sur la base des Big Data ?

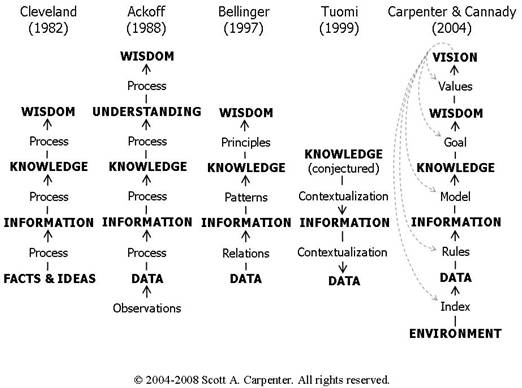

A la base, une confusion s’entretient entre donnée, information, connaissance et savoir. Les théories de la connaissance existent pourtant depuis longtemps. Celle de Russell Ackoff est la plus répandue mais elle n’est ni la première, ni la dernière. Scott Carpenter*, dans un article en ligne, en a résumé les principaux avatars ici :

La donnée, placée comme élément brut, y est toujours placée en bas, quelle que soit la théorie concernée. La connaissance, et le stade ultime, la vision, n’étant que la résultante de ces données au prisme de l’individu (les règles transforment la donnée en information, les modèles en connaissance, les buts en sagesse, et les valeurs en vision).

Qui plus est, Ackoff est allé jusqu’à établir des hypothèses sur le pourcentage du temps dédié à chacune des étapes par le cerveau humain : alors que les données accaparent 40% du temps de cerveau disponible (il appelle cela « mental space »), la couche de l’information se voit allouer 30% de ce temps, la connaissance 20%, et seulement 10% sont disponibles pour les couches les plus nobles. Alors que la théorie d’Ackoff a été développée en 1989, à une époque où la recherche des données était un travail assez ardu et seulement partiellement automatisé (les ordinateurs personnels commençaient juste à se généraliser aux USA à cette époque-là), la période d’automatisation forte que nous connaissons aujourd’hui devrait permettre, selon le Pr Carpenter, de se concentrer sur les tâches les plus nobles, donnant ainsi corps à la sentence attribuée à Einstein qui prétendait que « l’imagination est plus importante que le savoir ».

La question ici est de savoir si les Big Data, près de 30 ans plus tard, ont changé la donne. La connaissance est-elle devenue statistique ? Les modèles mathématiques permettent-ils de se passer des hommes ? Ces décisions sont-elles meilleures du fait de ces algorithmes ? Pour me faire une idée plus précise de la question, je me suis penché sur un webinaire organisé par l’université de Stanford aux USA et qui, grâce aux miracles de la technologie, m’a permis d’atteindre la connaissance (voilà déjà un point où l’accumulation de données vidéo aura clairement eu un résultat positif).

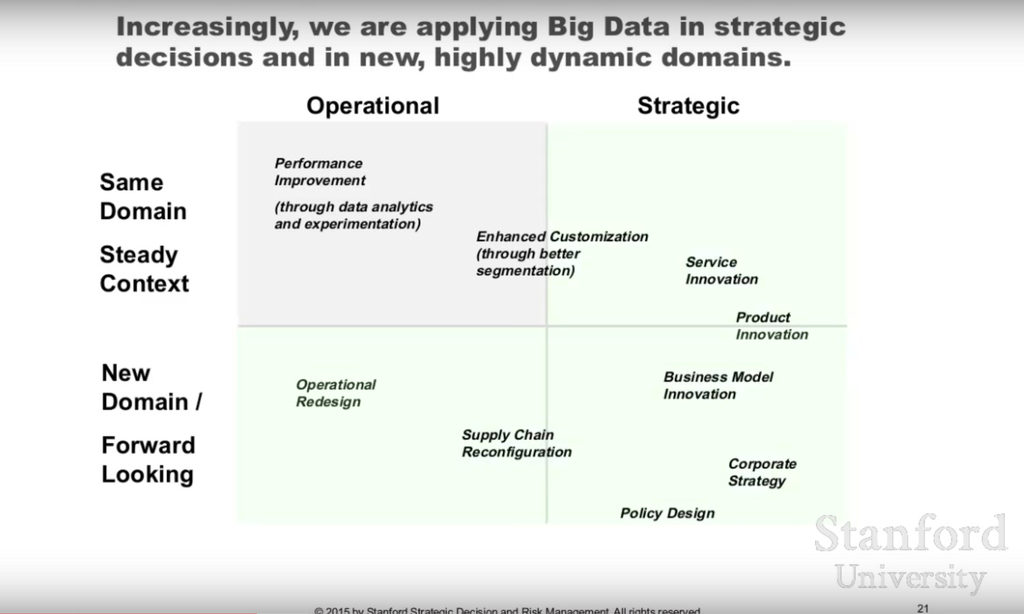

Il faut tout d’abord faire la part du feu entre décisions opérationnelles et décisions stratégiques, non que les unes soient plus importantes que les autres. Les Big Data offrent certes un fort volume de données, une grande variété et vitesse de rafraîchissement (la fameuse théorie fondatrice des 3V de Meta Group), mais selon les animateurs de Stanford, il n’y a pas de corrélation entre la pertinence de la donnée et son abondance, fût-elle en croissance exponentielle.

En fait, malgré les envolées lyriques des technophiles, « on est juste capable de gratter la surface » ont prévenu les organisateurs du Webinaire de Stanford : « seules 0.5% des données sont disponibles pour prendre des décisions ». J’avais déjà eu vent d’interprétations similaires, qui plaçaient le pourcentage des données réellement disponibles pour l’analyse à 1 % (selon information builders). Peu importent les chiffres, sachons juste que les volumes de données réellement disponibles n’ont décidément rien à voir avec les volumes stratosphériques annoncés dans toutes les conférences.

Ce n’est pas tout : ce qui a changé ces derniers temps, c’est que par le passé, nous étions capables d’améliorer les algorithmes. Ce n’est désormais plus le cas. C’est ce que confirme Peter Norvig de Google (l’article est sous embargo mais disponible si vous cherchez bien) selon lequel « nous n’avons pas de meilleurs algorithmes à disposition, nous avons juste davantage de données ». De même, le fait d’avoir plus de données ne garantit pas de meilleurs résultats. Enfin pas toujours.

Dans le futur, ce ne sera plus l’accès aux données qui sera discriminant, car les fournisseurs de données seront de plus en plus aptes à fournir des connecteurs et des API. Ce qui va changer la donne, c’est la capacité de poser les bonnes questions (le fameux processus de décision).

Preuve à l’appui, il est des exemples où la combinaison Big Data / décision humaine fonctionne très bien. Beaucoup d’applications Big Data se sont focalisées ainsi sur les décisions opérationnelles (amélioration des performances) dans un domaine particulier.

Volvo Trucks par exemple, a utilisé les Big Data pour son processus de contrôle de sa flotte de véhicules professionnels : cela génère un volume de données important, 1GO par camion et par heure, et permet d’améliorer la programmation des entretiens, d’améliorer l’efficacité de l’utilisation des carburants, et de diagnostiquer les problèmes techniques à distance.

D’autres entreprises vont plus loin et n’hésitent pas à utiliser les Big Data pour alimenter leur processus de décision stratégique. C’est le cas de Persado qui utilise des algorithmes lui permettant de formaliser ses discours marketing via e-mail. Son directeur marketing décrit ce processus comme « la résolution d’un problème mathématique résultant en la création du message le plus persuasif ».

Plus classiques, les exemples dans le domaine de la santé abondent également.

Ainsi, si l’on amène les responsables métiers et les experts des Big Data (les data scientists) on peut non seulement perfectionner la démarche rétrospective d’amélioration continue, mais aussi prendre de meilleures décisions plus prospectives et stratégiques.

Sur ce point, les analystes animateurs de notre webinaire sont clairs. « Il est certain que les Big Data changent la nature du contenu » nous dit James Matheson de Smartorg, « par contre, pour ce qui est du processus de décision, cela est beaucoup moins sûr ».

Les Big Data vont permettre, au travers de données, d’identifier des tendances par extrapolation. Par contre, pour ce qui est de découvrir les tendances cachées, « vous aurez toujours besoin des humains, comme dans la recherche et développement ».

Peter Thiel SV, créateur de Paypal et auteur de ZERO TO ONE a écrit à ce sujet : « c’est une idée bien étrange de croire que le futur puisse ressembler au passé. Mais c’est pourtant l’hypothèse posée par la science de la statistique ».

On peut donc envisager que regarder le monde dans son rétroviseur est assez inutile, et risque même de vous mener vers de mauvaises décisions. Peut-on par exemple imaginer rétrospectivement que, munis de Big Data et de données pertinentes, les décideurs de Digital Equipment (DEC), qui disparut dans les années 2000, auraient pu voir venir la tendance des ordinateurs personnels et de l’informatique distribuée (qui a tué son business des mini-ordinateurs de façon inexorable) ? En fait, les familiers du secteur le savent, tout le monde voyait venir cette évolution depuis très longtemps. Ce n’est pas l’absence de données qui a conduit à cette mauvaise décision. Ajouter des données n’y aurait rien changé.

Tout compte fait, le processus de décision n’a pas tellement changé au cours du temps. Selon les animateurs du webinaire de Stanford, les conclusions propres à mener à des décisions ne peuvent venir que d’un analyste humain.

La notion même de « bonne décision » est une notion éminemment subjective, les résultats se mesurant rarement de façon binaire (bons ou mauvais). Il n’y a donc plus qu’à attendre que le machine Learning et l’intelligence artificielle fassent des progrès tels que les machines deviennent douées d’intelligence et d’imagination. C’est sans doute sur ce point que j’attends l’intelligence artificielle avec le plus d’impatience, car s’il est possible de reproduire l’intelligence rationnelle jusqu’à un certain point, l’intelligence émotionnelle, mère de l’intuition, est beaucoup plus difficile à reproduire. Et au cas où l’on y arriverait, de la même manière que le professeur Steven Hawking et quelques autres, je pense que la race humaine aurait alors tout lieu de s’inquiéter.

En attendant, pour augmenter la pertinence des décisions d’entreprise à partir des Big Data, il faudra construire des équipes pluridisciplinaires, afin d’interpréter au mieux les données disponibles.

Fort de ces enseignements, et de la conclusion du rapport de Carpenter cité plus haut, vous savez donc que si vous utilisez les Big Data de manière pertinente, en alimentant un processus de décision humain de qualité, vous aurez ainsi tiré le meilleur parti de ces nouvelles technologies pour prendre de bonnes décisions.

Besoin de booster votre efficacité commerciale et votre génération de leads ?

Sparklane vous permet :